您现在的位置是:主页 > 品牌 > 阿里巴巴 >

阿里推出全新视觉理解模型Qwen2-VL-72B,支持超长视频解析超过20分钟!

发布时间:2024年08月30日 15:41:56 阿里巴巴 人已围观

简介阿里通义千问于8月30日发布了第二代视觉语言模型Qwen2-VL,旗舰模型Qwen2-VL-72B的API已在阿里云百炼平台上线。该模型在多个权威测试中表现优异,刷新了多模态模型的最佳成绩,展现出强...

新标360快讯8月30日报道,阿里发布了第二代视觉语言模型Qwen2-VL,旗舰模型Qwen2-VL-72B的API已在阿里云的百炼平台上线。

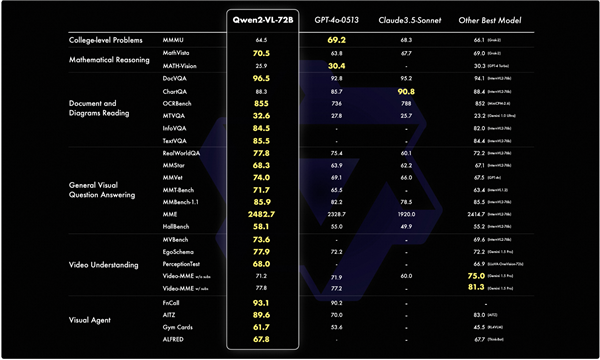

据悉,Qwen2-VL在多项权威评测中刷新了多模态模型的最佳纪录,并在部分指标上超越了如GPT-4o和Claude3.5-Sonnet等闭源模型。

2023年8月,阿里开源了第一代视觉语言理解模型Qwen-VL,迅速成为开源社区中最受欢迎的多模态模型之一。

在短短一年内,该模型的下载量已超过1000万次。目前,多模态模型在手机、汽车等多种视觉识别场景中的应用逐步加速,开发者和应用企业对Qwen-VL的升级也表现出极大的关注。

相比于前一代,Qwen2-VL的基本性能得到了显著提升,能够理解不同分辨率及长宽比的图像,并在MathVista、DocVQA、RealWorldQA、MTVQA等基准测试中展现出全球领先的绩效。

此外,Qwen2-VL能够理解超过20分钟的长视频,支持视频问答、对话及内容创作等多种应用。同时,具备强大的视觉智能体功能,能够自主操控手机和机器人,凭借其复杂的推理与决策能力,Qwen2-VL可以集成到手机、机器人等设备中,根据视觉信息和文本指令进行自动化操作。

该模型还能理解图像视频中的多种语言文本,包括中文、英文、大部分欧洲语言、日语、韩语、阿拉伯语、越南语等。

通义千问团队从六个方面评估了模型的能力,包括大学题目的综合能力、数学能力、多语言文档表格的理解、通用场景问答、视频理解及智能体能力。

在大多数评测指标上,Qwen2-VL-72B表现优异,甚至超过了GPT-4o和Claude3.5-Sonnet等闭源模型,尤其在文档理解方面展现出明显优势,仅在综合大学题目方面与GPT-4o存在一定差距。

用户可通过阿里云百炼平台调用Qwen2-VL-72B的API:https://help.aliyun.com/zh/model-studio/developer-reference/qwen-vl-api