您现在的位置是:主页 > 科技圈快讯 > 最新 >

DeepSeek推出了一项重大突破

发布时间:2024年12月29日 14:14:40 最新 人已围观

简介DeepSeek于12月26日发布DeepSeek-V3,这是一个先进的混合专家语言模型。该模型的主要技术进展包括671B的混合专家结构和37B的激活参数,并在14.8万亿个高质量token上进行了预训练。...

12月26日消息,国产大模型DeepSeek发布了其新版本DeepSeek-V3,作为一个强大的混合专家(Mixture-of-Experts, MoE)语言模型,其主要技术进步在于拥有671B的MoE和37B的激活参数,基于14.8万亿的高质量token进行了预训练。

AI界评论称,“这个圣诞节真的令人惊喜”。

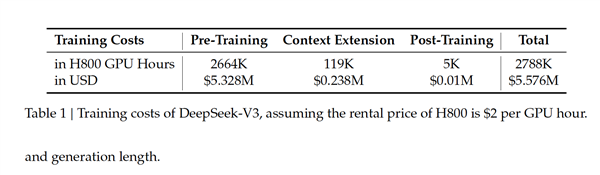

翻译来看,根据DeepSeek的发布报告所述,“尽管性能卓越,但DeepSeek-V3的完整训练耗时仅为2.788M H800 GPU小时。”

以Llama 3系列模型为例,其计算时间预算为3930万H100 GPU小时——这意味着可以对DeepSeek-V3进行约十五次的训练。

从成本角度来看,如果假设H800 GPU的租赁费用为每小时2美元,DeepSeek-V3的总训练费用仅为557.6万美元。

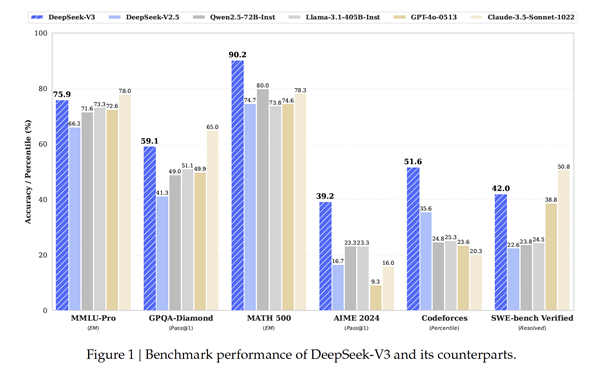

此外,在最新的技术报告中,DeepSeek-V3与多款模型如DeepSeek-V2.5、Qwen2.5-72B-Inst、Llama-3.1-405B-Inst、GPT-4o-0513和Claude-3.5-Sonnet-1022进行比较,结果显示其在多个性能基准测试中表现优异。

在MATH500、AIME2024和Codeforces等多个维度上,DeepSeek-V3的表现尤其突出,展现了强大的数学和编程能力,其表现甚至超越了GPT-4o以及Claude 3.5 Sonnet这两款顶尖的闭源模型。

虽然在某些语言理解与软件工程的任务中稍显不足,但依然是表现最好的前两名选择。

DeepSeek表示,这得益于其采用的Multi-head Latent Attention (MLA)和DeepSeek MoE架构,实现了高效的推理和经济的训练过程。

同时,项目引入了辅助损失自由负载平衡的策略及多token预测训练目标,以提升模型性能。在14.8万亿高质量token的预训练以及后续的监督微调与强化学习阶段中,最大程度地发挥了模型的潜力。

综合评估结果显示,DeepSeek-V3不仅在与其他开源模型的比较中表现优越,其性能也接近领先的闭源模型。并且,训练过程极为稳定,未出现无法恢复的损失峰值或回归问题。相较之下,ChatGPT在同一天出现宕机情况,尚未恢复。

Meta AI的研究科学家田渊栋在X平台上对DeepSeek-V3的“有限预算”与“卓越表现”感到很惊讶。

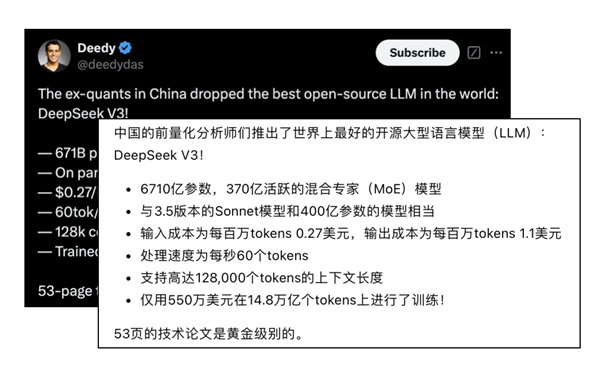

曾是Glean及Google Search的创始团队成员的风投Deedy更是称赞DeepSeek-V3为“全球最佳的开源大模型”。

DeepSeek-V3的基础模型依据英语与中文为主的多语言语料库进行预训练,其效果主要在以英语和中文为主的基准测试中得以评估,同时也参与了一项多语言基准测试。其内部集成的HAI-LLM框架的具体得分如下: