您现在的位置是:主页 > 科技圈快讯 > 最新 >

微软论文意外泄露,揭示GPT核心秘密:4o-mini仅8B,o1仅300B!

发布时间:2025年01月02日 11:04:17 最新 人已围观

简介微软在最新的论文中意外泄露了OpenAI的机密信息,具体提到o1-preview约有300亿参数,GPT-4o约有200亿参数,而GPT-4o-mini则为8亿参数。英伟达计划在2024年初发布的B200中确认,GPT-4的规格为1....

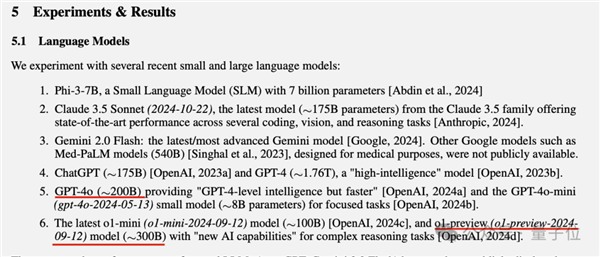

微软又曝出OpenAI的相关数据泄露?在一项论文中显而易见地提到:

o1-preview大约300B参数,GPT-4o大约200B,GPT-4o-mini约8B……?

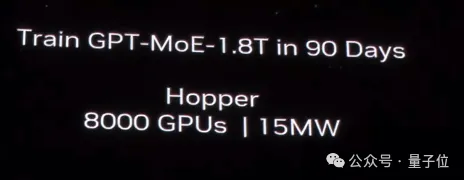

英伟达在2024年初推出B200时,明确表示GPT-4的参数为1.8T MoE,也就是1800B,而微软提供的数字则更精确,显示为1.76T。

此外,论文中也指出了OpenAI的mini系列以及Claude3.5 Sonnet的参数,具体总结如下:

- o1-preview大约300B;o1-mini大约100B

- GPT-4o约200B;GPT-4o-mini约8B

- Claude 3.5 Sonnet 2024-10-22版本约175B

- 微软自己的Phi-3-7B,这个明确就是7B

虽然论文末尾有免责声明:

一些数据尚未正式发布,以上大部分数字仅为估算。

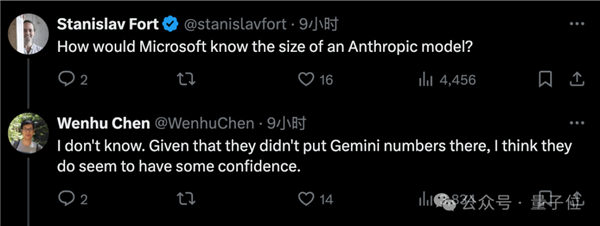

但是,依然有不少人对此表示怀疑。

例如,为什么唯独没有披露谷歌Gemini模型的参数估计?或许他们对发布数据的准确性相当自信。

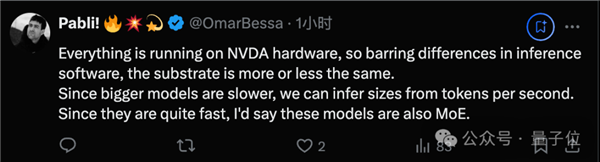

也有人推测,大部分模型都在英伟达GPU上运行,因此可以通过token生成速度来进行估算。

而谷歌的模型则采用TPU运行,这就使得估算变得困难。

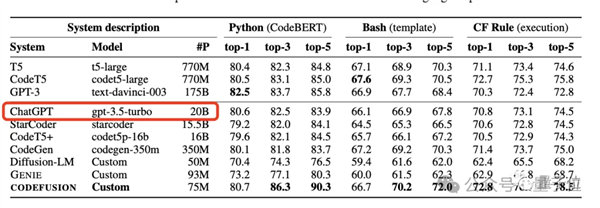

此外,微软这样的事情并非第一次。

在2023年10月,微软在一篇论文中“意外”泄露了GPT-3.5-Turbo的20B参数,而后在更新版本中又将此信息删除。

那么,你觉得这是故意的还是偶然的呢?

微软论文提及的内容

其实,该论文介绍的是一个与医疗相关的基准测试——MEDEC。

该研究于12月26日发布,但由于其较为专业,可能不相关领域的读者并未关注,直到年后被相关网友挖掘出来。

研究的动机是,由于美国医疗机构的调查显示,有五分之一的患者在阅读临床记录时发现错误,而其中40%的患者认为这些错误可能会影响他们的治疗。

与此同时,大语言模型(LLMs)在医学文档处理中的应用正日益增加(如生成治疗方案)。

因此,MEDEC设定了两个任务:一是检测并识别临床记录中的错误;二是能够进行纠正。

下一篇:没有了