您现在的位置是:主页 > 品牌 > 字节跳动 >

科技博主阑夕:大模型不仅在价格上竞争,还在并发能力上较量

发布时间:2024年05月22日 10:14:41 字节跳动 人已围观

简介科技博主阑夕分析了近期大模型降价潮,提到豆包通用模型lite-4k/32k和通义千问qwen-long的千tokens推理输入价格分别为0.3厘和0.5厘,以及百度文心ERNIE系列的永久免费策略。这一趋势反映了...

豆包通用模型lite-4k/32k的千tokens推理输入价格为0.3厘;通义千问qwen-long则为0.5厘;而百度文心ERNIE Speed和ERNIE Lite则宣布将免费提供。

针对近期大模型价格普降的现象,科技博主阑夕在文章中表示:在业界,谈及千Tokens的定价,仅仅降低价格是不够的,如果吞吐量过小,即使再便宜也无济于事。单纯降价,一旦吞吐能力依旧微薄,那也只是徒劳无功。

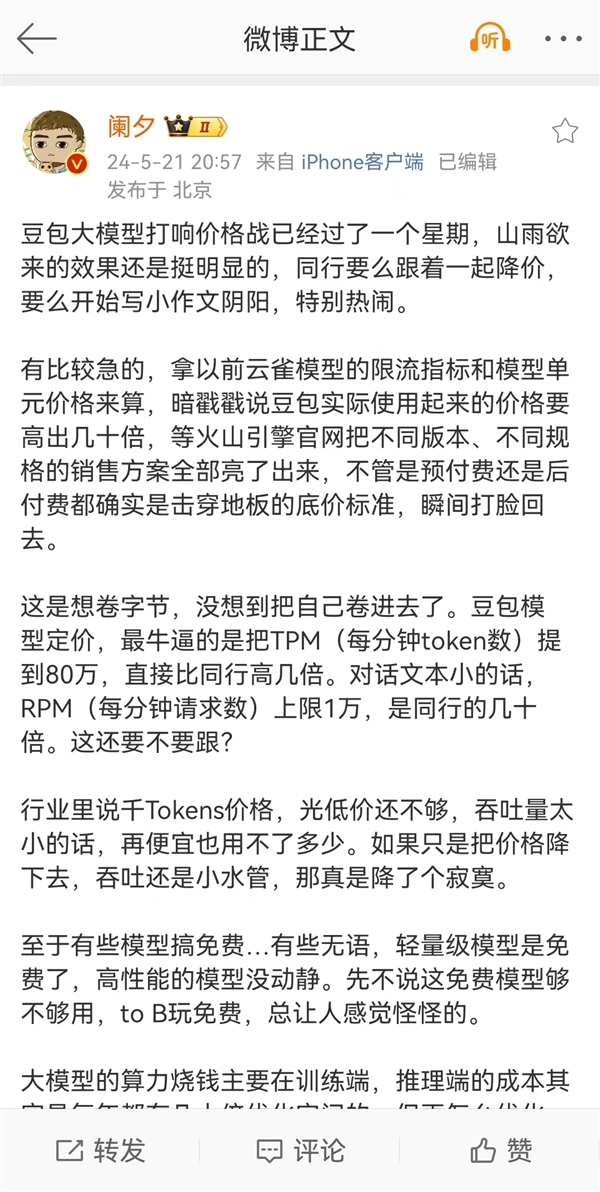

以下是阑夕在微博上的重要见解:

自豆包大模型开启价格战已经过了一周,市场的紧张氛围愈加明显,竞争对手或是紧随其后降价,或是开始发表各自看法,场面异常热闹。

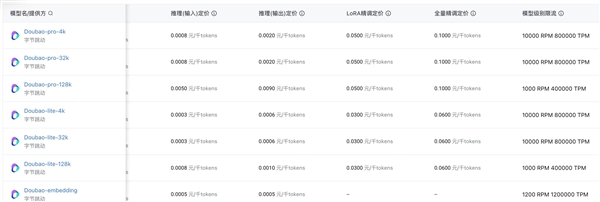

有些企业着急地用以前云雀模型的流量限制与单元价格进行比较,试图暗示豆包的实际使用成本偏高。但当火山引擎官方网站公布各版本、不同规格的售卖方案后,无论是预付费还是后付费,都毫不犹豫地以底价冲击市场,立刻反击了这些质疑。

豆包模型的定价中,最为引人注目的在于将TPM(每分钟token数)提升至80万,远高于行业内一般在10万到30万tokens的水平。如果对话文本简短,RPM(每分钟请求数)上限为1万,其支持的并发量是同行的几十倍(一般为60到120,轻量版为300到500)。其他大型模型会怎么应对呢?

在行业内,谈论千Tokens的价格,不仅要关注价格的低廉程度,还需关注吞吐量,如果吞吐量不理想,那么再便宜也没有实际意义。单方面降低价格,却不提升吞吐量,那么这样的降价便显得毫无意义。

(关于免费的问题)大模型的算力开销主要发生在训练阶段,而推理阶段的成本实际上每年都有巨大的优化空间。但即便如此,最终成本也不可能降至为零。

如果价格足够低,同时还能盈利,这样就能够促进应用和商用市场的扩大,OpenAI等主流大模型开发者都是如此运作,尽管商业竞争可能不太讲究,但商业规律依然是需要被尊重的。

总的来说,大模型目前仍处于拓展市场的阶段,更多企业参与帮助降低企业进入的成本,最终也是一种共赢的局面。

Tags: 字节跳动